NVIDIA ACE to nowy projekt zaprezentowany na pokazach Computex 2023. Firma przedstawia system, który pozwoli nam prowadzić rozmowę ze sztuczną inteligencją w grach. Jak brzmią NPC używające AI i czy ten pomysł ma sens.

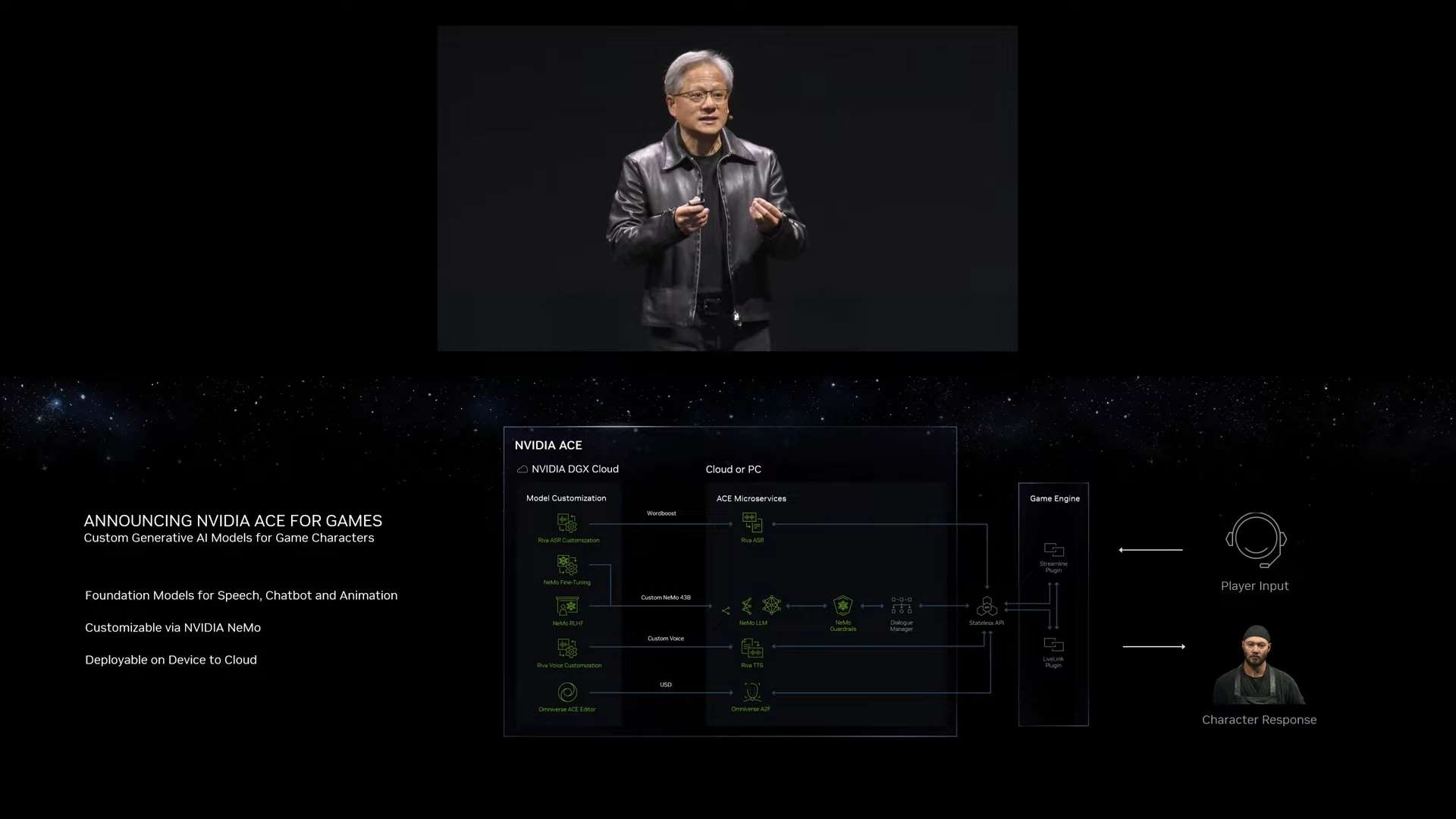

Modele językowe oraz szeroko pojęta sztuczna inteligencja przejmują coraz więcej sfer naszego życia. Zdanie zarówno sztampowe, jak i prawdziwe. Tym razem AI wchodzi do świata cyfrowej rozrywki. Na tegorocznych targach Computex, NVIDIA na swoim panelu zaprezentowała NVIDIA ACE – system, który pozwoli, zamiast rozpisywać postaciom niezależnym, wcześniej przygotowane linie dialogowe, implementować sztuczną inteligencję, która będzie generować unikalne odpowiedzi.

NVIDIA ACE – jak to działa?

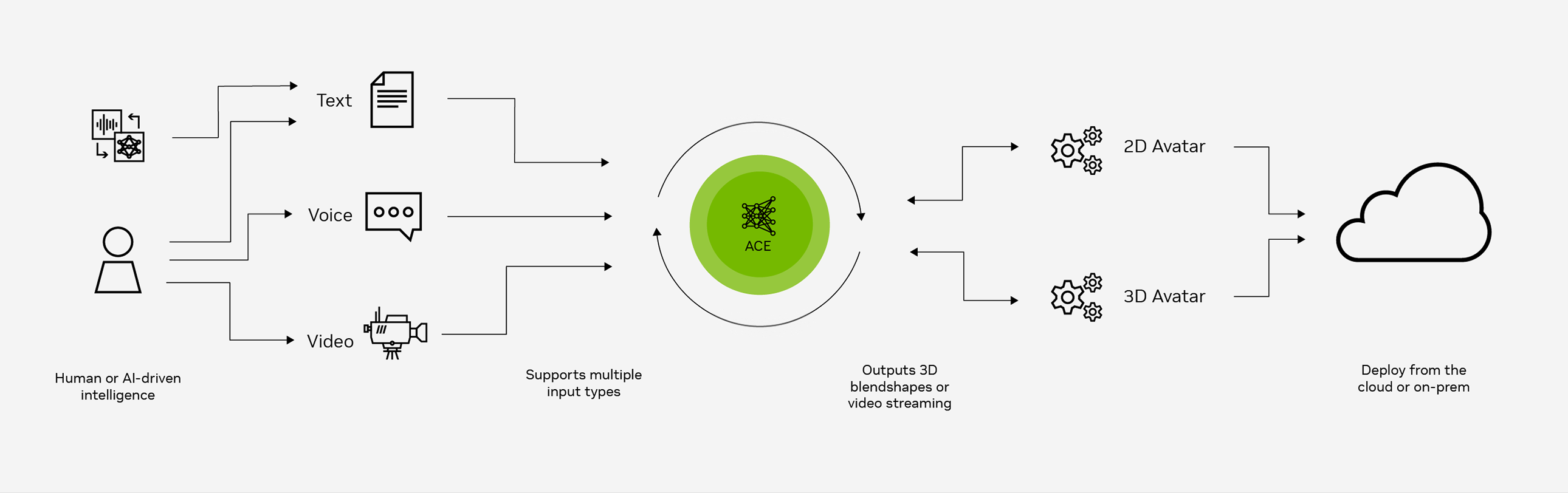

Zacznijmy od rozszyfrowania skrótu nowego projektu firmy. ACE to Avatar Cloud Engine (Avatar silnika chmury) i słowo cloud jest w tym przypadku kluczowe. NVIDIA jest znana z wykorzystywania technologii chmury. Są autorami jednego z nielicznych programów do cloud gamingu, który działa, więc o zaplecze technologiczne raczej nie należy się martwić.

ACE będzie narzędziem dla pracowników z branży gamedev, które zdejmie z nich obowiązki pisania dialogów dla NPC. Umieszczony w chmurze skrypt AI, będzie na bieżąco generował odpowiednie odpowiedzi dla postaci. Umożliwi to prowadzenie płynniejszej rozmowy, która da więcej swobody graczowi. NVIDIA zapowiada też, że w przyszłości dołączą opcję uczenia się wzmacniającego na podstawie informacji zwrotnych od ludzi (RLHF), by jeszcze bardziej ułatwić zadania programistom.

ACE jednak nie byłby taką rewolucją, gdyby było jedynie generatorem tekstu. NVIDIA podjęła współpracę z startupem Convai, pracującym już wcześniej przy tego typu projektach i zaprezentowali wspólnie demo technologiczne. Zastosowano technologię zmiany mowy na tekst i na odwrót (NVIDIA NeMO do LLM) oraz program dopasowujący odpowiednią mimikę twarzy do wygłaszanych kwestii (Audio2Face). Pozwala to rozmawiać za pomocą mikrofonu z realistycznymi bohaterami… tylko, że nie.

Łyżka dziegciu

Gdy jesteśmy już przy demie technologicznym, całkowicie rozumiem, że NVIDIA jest dopiero na początku pracy z ACE, ale to, co zaprezentowano na nagraniu, wygląda po prostu kiepsko. Tekst jest wygłaszany bez emocji, a same kwestie przypominają najgorsze dialogi z gier Bethesdy. Najlepiej sprawdza się technologia Audio2Face i to ona najszybciej będzie użyta w pełnoprawnym tytule, skorzysta z niej między innymi S.T.A.L.K.E.R 2: Heart of Charnobyl.

Natomiast jest to kierunek, w którym branża po prostu idzie i należy się temu bacznie przyglądać. Swoje projekty NPC AI zapowiedział już w marcu Ubisoft i pewnie wiele podmiotów trzecich wykorzysta ACE. Liczę, że wykorzystane to będzie jedynie do nieistotnych postaci, zlecających zadania, bo chciałbym się jeszcze zachwycić kimś pokroju Vaasa, czy GLADOS (ironiczne, że nie chcę, by postać robota, pisał robot).

![DailyWeb testuje: [WYWIAD] Które języki tłumaczy się najtrudniej? O AI, pięknych urządzeniach, projektowaniu produktów dla seniorów i młodych – rozmawiamy z Kamilem Cupiałem z VASCO](https://alfred.dailyweb.pl/wp-content/uploads/2022/01/wywiad-1-300x250.png)