OpenAI, znane z rozwoju technologii sztucznej inteligencji, ogłosiło nową politykę moderacyjną, która ma w znaczący sposób zwiększyć bezpieczeństwo odpowiedzi generowanych na bazie AI, a ponadto odciążyć zespoły ekspertów czuwających nad jakością treści.

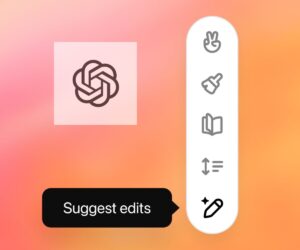

W oficjalnym wpisie na swoim blogu OpenAI opisało technikę polegającą na przekazywaniu modelowi GPT-4 konkretnych wytycznych, które kierują nim w podejmowaniu decyzji o stopniu moderacji. Nieznana jest skala odpowiedzi, które są moderowane przez ekspertów OpenAI, jednak już od dawna użytkownicy apelowali o zwiększenie jakości treści, które przedstawia model sztucznej inteligencji.

Dopóki radzimy się ChatGPT w zakresie życiowych decyzji takich jak „przepis na szarlotkę” czy „ból głowy przyczyny”, jakość odpowiedzi można w łatwy sposób zweryfikować. Przy tematach z pogranicza legalności, jak w każdej platformie społecznościowej, zdecydowanie wymagana jest większa kontrola i natychmiastowa reakcja. W końcu możemy sobie wyobrazić, co by się stało, gdyby ChatGPT odpowiadał z lekką ręką na pytanie „gdzie kupię broń”? Twórcy OpenAI deklarują, że nowy model ma być odporny na takie pułapki.

ChatGPT z większym naciskiem na jakość

Kto namiętnie używa ChatGPT, ten zauważy, że w modelu językowym co rusz pojawiają się i znikają nowe funkcje. Jedną z bardziej tajemniczych było połączenie z wynikami wyszukiwania Bing, które szybko zostało wygaszone ze względu na zbyt dużą liczbę nieodpowiednich i niestosownych odpowiedzi. Zapewne było to jedno z przełomowych momentów, w którym użytkownicy zaczęli się orientować, że coś jest nie tak z jakością wyszukiwań. Nic zresztą dziwnego, przy tak ogromnej skali danych, na której uczy się ChatGPT, bardzo łatwo zwieść go na manowce i przystosować tylko do błędnych rozwiązań. Gorliwi użytkownicy przyznają, że już widać spadek jakości i zwiększoną liczbę błędów, jakie przedstawia ChatGPT. Nie mówiąc o tym, że model językowy sam w sobie nie jest w stanie ocenić, co jest prawdą a co nie. Jeśli znajdzie w internecie przepis na szarlotkę z dodatkiem pieczarek, przyjmie założenie że to prawidłowy przepis. Bo skąd ma wiedzieć co jest w szarlotce?

Asystent Google będzie jeszcze lepszy? Wykorzysta technologię ChatGPT

Eksperci od polityki jakości w firmie OpenAI oznaczają przykłady niestosownych odpowiedzi i przekazują je modelowi GPT-4 bez etykiety, obserwując, jak dobrze oznaczenia modelu zgadzają się z ich ocenami, a następnie doskonalą na tej bazie swoją politykę. Firma twierdzi, że jej proces, którego już używają niektórzy klienci, może skrócić czas wprowadzania nowych polityk moderacji do kilku godzin.

„Analizując różnice między ocenami GPT-4 a ludźmi, eksperci mogą prosić GPT-4 o uzasadnienie swoich etykiet, analizować niejasności w definicjach polityki, rozwiązywać nieporozumienia i dostarczać odpowiednie wyjaśnienia,” twierdzi OpenAI.

Jak zawsze dylematy natury etycznej

Jednak nie wszyscy użytkownicy są przekonani co do słuszności kierunku, w którym zmierza ChatGPT. Narzędzia do moderacji oparte na AI nie są przecież nowością. Zawsze gdy w grę wchodzi czynnik ludzki, mowa jest o możliwym uprzedzeniu bądź celowemu wprowadzeniu w omyłkę. Nie zawsze działają zatem takie mechanizmy bezbłędnie. Co jeśli moderator czuwający nad treściami jest uprzedzony do osób innego koloru skóry? Albo faworyzuję rozwiązania w swoim ojczystym języku?

Kilka lat temu zespół analityków pracujących nad jakością wyników odpowiedzi odkrył, że posty w mediach społecznościowych dotyczące osób niepełnosprawnych były często oznaczane jako bardziej negatywne przez popularne modele wykrywania sentymentu. Część tych błędów wynika z uprzedzeń osób oznaczających dane treningowe.

Czy OpenAI rozwiązało ten problem? Wydaje się, że nie do końca. Firma sama przyznaje: „Oceny dokonywane przez modele językowe są podatne na niechciane uprzedzenia wprowadzone podczas treningu. Wyniki muszą być starannie monitorowane przez ludzi.”

Być może siła predykcyjna GPT-4 pomoże osiągnąć lepszą jakość moderacji niż wcześniejsze platformy. Ale nawet najlepsza dzisiejsza AI popełnia błędy, zwłaszcza w kwestii moderacji.

![DailyWeb testuje: [WYWIAD] Które języki tłumaczy się najtrudniej? O AI, pięknych urządzeniach, projektowaniu produktów dla seniorów i młodych – rozmawiamy z Kamilem Cupiałem z VASCO](https://alfred.dailyweb.pl/wp-content/uploads/2022/01/wywiad-1-300x250.png)