Według YouTubera MKBHD, algorytmy przetwarzające zdjęcia z iPhone’ów istotnie pogarszają ich jakość. W niektórych przypadkach dochodzi do całkowitej degradacji, co czyni fotografię bezużyteczną.

Aparaty montowane w dzisiejszych smartfonach mają spore ograniczenia sprzętowe. Zasadniczo, takowe występowały od początku historii fotografii mobilnej i choć staramy się przekraczać granice, jeszcze długo nie będziemy mogli osiągnąć tyle, na ile pozwalają fizyczne rozwiązania. Producenci telefonów skupili się więc na oprogramowaniu, którego nie imają się ograniczenia. Tym samym, algorytmy działające po wykonaniu zdjęcia są w stanie czynić cuda w procesie postprodukcji. Przez postprodukcje nie mam tu na myśli manualnej obróbki zdjęć czy wywoływania RAW-ów, lecz automatykę działającą w ułamku sekund po wykonaniu ujęcia. Algorytmy, a konkretnie – efekty ich pracy, robią wrażenie, ale wygląda na to, że producenci poszli nieco za daleko.

iPhone’y robią coraz gorsze zdjęcia – winowajcą okazują się algorytmy

Dla wyjaśnienia – to czysto subiektywna opinia, która w dużej mierze pokrywa się z tym, co przedstawił YouTuber MKBHD na swoim kanale. Wspomniany twórca skupił się na temacie iPhone’ów, ale moje doświadczenia podpowiadają, że podobnie wygląda to także w obozie Androida. Apple jest jednak na etapie dopieszczania nowej kamery, przez co algorytmy działające w najnowszych smartfonach iPhone 14 Pro i iPhone 14 Pro Max mogą „niedomagać”. Wyjaśnijmy.

Przez wiele lat Apple ograniczało się do stosowania głównych sensorów fotograficznych o rozdzielczości 12 MP. W ten sposób, coroczne usprawnienia programowe dosłownie wyciskały z matrycy siódme poty. Zdjęcia cieszyły oko, były dopieszczone i to niezależnie od warunków oświetleniowych. Każda kolejna edycja Smart HDR czy Deep Fusion robiły robotę, bo działały na znanym im hadrware. W najnowszych smartfonach zastosowano 48 MP matrycę i to okazało się problemem nie do przeskoczenia.

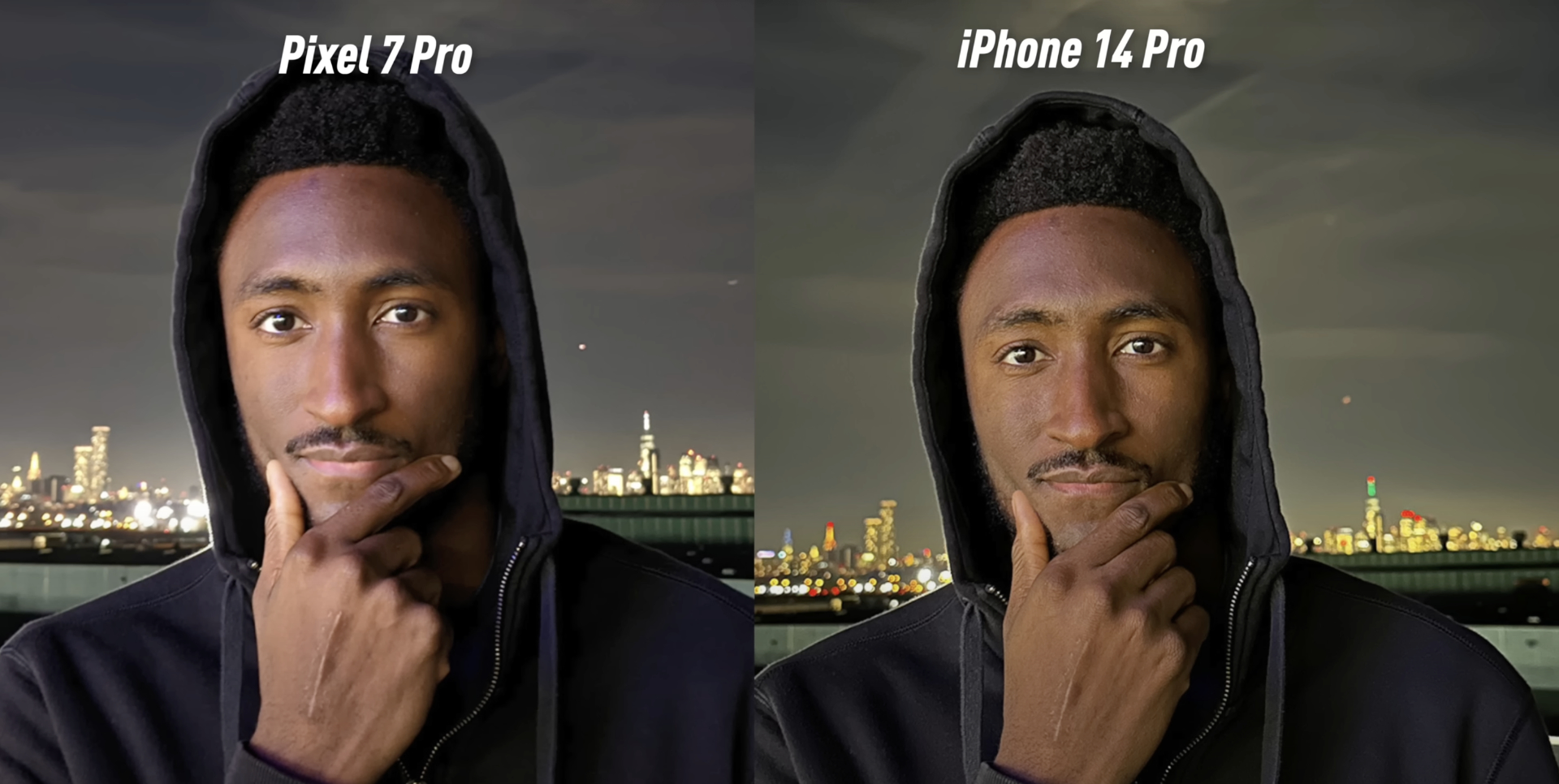

W dużym uproszczeniu – iPhone’y wykonują wiele zdjęć w różnych nastawach, z różną prędkością, a następnie efekty łączone są przez algorytmy tworzące finalny obrazek. Fakt, materiał wyjściowy jest istotny, ale to automatyka, niezauważalna dla użytkownika, czyni cuda. Sęk w tym, że niekiedy ostro przesadza. Dobrym przykładem będzie powyższe zdjęcie. Jak widać, gorsze warunki oświetleniowe czynią, że obraz uzyskany przez oprogramowanie jest dosłownie karykaturalny. Nie dzieje się to przy każdym ujęciu, ale bez wątpienia mamy do czynienia z realnym problemem. Jak mniemam, Apple poradzi sobie z nim w kolejnych generacjach modułu. Jeśli nie chcemy czekać, możemy skorzystać z aplikacji typu Halide Camera czy Momentum Camera, które pozwalają na manualne nastawy. To półśrodek, ale skuteczny.

Permanentny koniec serii iPhone SE – dające nadzieję przecieki okazały się nietrafione

![DailyWeb testuje: [WYWIAD] Które języki tłumaczy się najtrudniej? O AI, pięknych urządzeniach, projektowaniu produktów dla seniorów i młodych – rozmawiamy z Kamilem Cupiałem z VASCO](https://alfred.dailyweb.pl/wp-content/uploads/2022/01/wywiad-1-300x250.png)